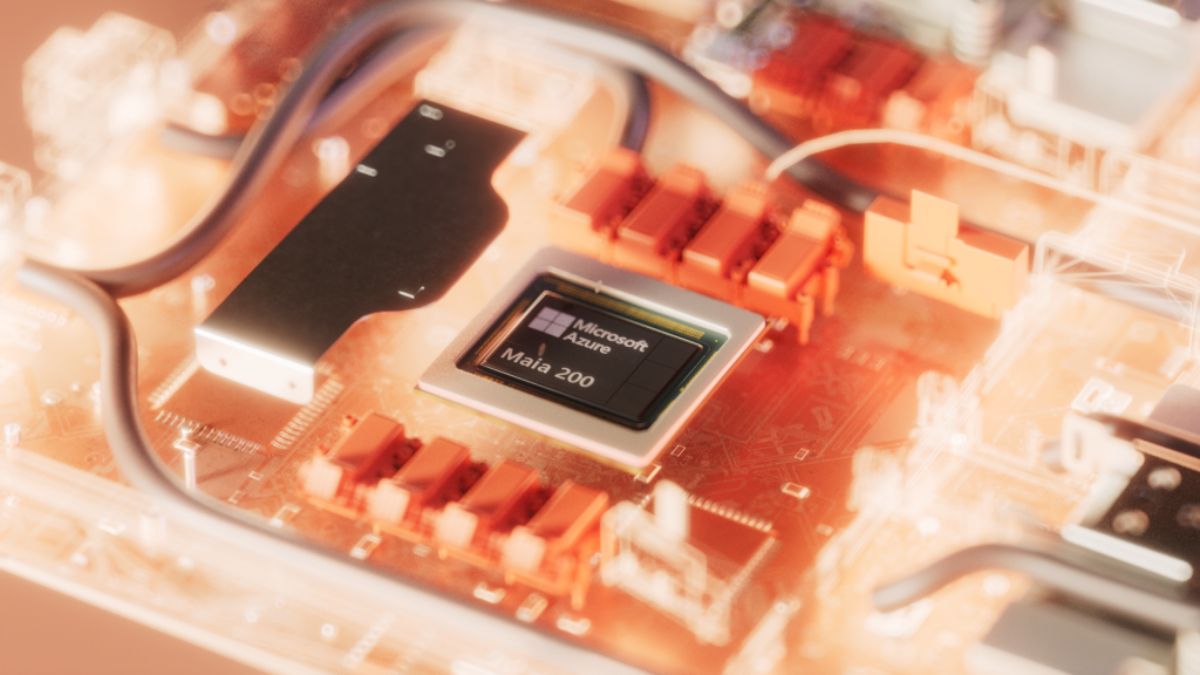

Microsoft bouscule l'hégémonie de Nvidia avec son accélérateur Maia 200

Face à l'explosion des coûts de l'IA générative, Microsoft dégaine son arme fatale avec la puce Maia 200. Gravé en 3 nanomètres par TSMC, cet accélérateur d'inférence ne se contente pas de booster les performances, il redessine l'économie entière des centres de données pour soutenir l'arrivée imminente de GPT-5.2. Plus qu'une simple mise à jour matérielle, c'est une offensive stratégique pour briser la dépendance au silicium externe.

Le géant de Redmond change radicalement d'échelle dans sa guerre froide contre les fabricants de puces traditionnels.

Cette nouvelle itération matérielle repose sur une prouesse de fonderie avec l'utilisation du procédé 3 nanomètres de TSMC, permettant d'entasser plus de 140 milliards de transistors sur une seule surface de silicium. L'objectif affiché reste limpide : optimiser la rentabilité de la génération de jetons, ce processus coûteux qui donne vie aux réponses des agents intelligents. En intégrant des cœurs tenseurs FP8 et FP4 natifs, Microsoft cherche à maximiser le débit de calcul tout en minimisant la consommation énergétique globale. La puce délivre une puissance de calcul brute dépassant les 10 pétaFLOPS en précision 4 bits, une performance qui place le matériel bien au-dessus des standards actuels du marché.

Cette montée en puissance permet à la firme de réduire ses coûts d'exploitation de manière drastique pour ses services phares.

Silicium sur mesure et architecture de calcul haute fidélité

L'accélérateur Maia 200 représente l'aboutissement d'une stratégie d'intégration verticale poussée à son paroxysme.

Contrairement aux solutions génériques, ce processeur a été spécifiquement sculpté pour les charges de travail massives de l'IA, avec une attention particulière portée sur les modèles de langage de nouvelle génération. Microsoft revendique des performances trois fois supérieures à celles de la troisième génération d'Amazon Trainium pour les calculs en FP4, marquant un point critique dans la compétition entre les fournisseurs de cloud. La conception même de la puce a été guidée par des environnements de simulation pré-silicium extrêmement sophistiqués, modélisant les flux de communication des grands modèles de langage avant même la fabrication des premiers composants. Cette approche permet de s'assurer que le matériel répondra parfaitement aux exigences de production dès sa sortie d'usine.

Le résultat se traduit par un gain d'efficacité immédiat pour les utilisateurs des services Azure et de la suite Microsoft 365 Copilot.

Cette avance technique permet également à l'équipe Microsoft Superintelligence d'accélérer la création de données synthétiques de haute qualité.

L'utilisation de la Maia 200 pour le filtrage et la génération de ces données spécifiques au domaine alimente les cycles d'entraînement avec des signaux bien plus précis. En optimisant cette étape cruciale du pipeline de données, Microsoft améliore la pertinence de ses modèles internes tout en réduisant le temps nécessaire à leur apprentissage. La conception unique du processeur facilite le traitement de volumes massifs d'informations sans les ralentissements habituels liés aux transferts de données. On observe ici une volonté claire de maîtriser l'ensemble de la chaîne de valeur, du silicium jusqu'à la réponse finale fournie à l'utilisateur.

Cette accélération du cycle de développement est un atout majeur dans une industrie où chaque semaine de gagnée se chiffre en millions de dollars.

La guerre des données face au mur de la mémoire

La puissance de calcul ne représente qu'une partie de l'équation si la circulation des informations reste bridée par des composants lents.

Pour éviter ce goulot d'étranglement, Microsoft a doté son accélérateur d'un système mémoire massif composé de 216 Go de HBM3e, affichant une bande passante impressionnante de 7 To/s. Ce réservoir de données ultra-rapide est complété par 272 Mo de SRAM intégrée, agissant comme un tampon stratégique pour les opérations les plus fréquentes. Cette architecture permet de maintenir les cœurs de calcul constamment alimentés, évitant les cycles d'attente qui pénalisent l'efficacité des puces moins optimisées. Selon les analystes de Bloomberg Intelligence, ce type de configuration est indispensable pour faire tourner les modèles de la taille de GPT-5 sans faire exploser la facture énergétique.

L'enjeu est de taille : transformer la puissance brute en une fluidité d'exécution perceptible par le client final.

Le sous-système mémoire a été entièrement repensé pour inclure des moteurs de transfert de données spécialisés et une architecture de réseau sur puce dédiée.

Ces innovations permettent d'augmenter significativement le débit de jetons par seconde, une métrique capitale pour la satisfaction des utilisateurs de chatbots et d'assistants virtuels. En contrôlant directement la gestion de la mémoire, Microsoft s'affranchit des limites imposées par les architectures standards qui doivent rester compatibles avec une trop grande variété de tâches. La Maia 200 se concentre uniquement sur ce qu'elle sait faire de mieux : l'inférence à grande échelle. Cette spécialisation extrême est le secret de son rapport performance/prix supérieur de 30 % par rapport aux solutions de la génération précédente.

Il ne s'agit plus de fabriquer un processeur polyvalent, mais un outil de précision pour une tâche unique et vitale.

Une infrastructure réseau optimisée pour l'échelle mondiale

L'efficacité d'un processeur isolé ne signifie pas grand-chose sans une capacité de mise en réseau à la hauteur des enjeux du cloud mondial.

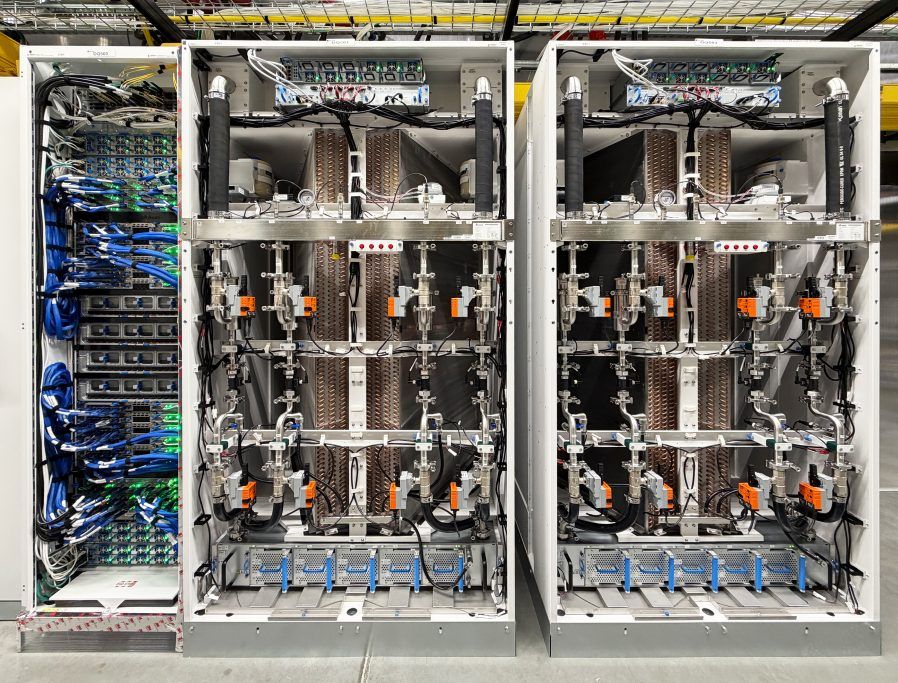

Microsoft introduit avec la Maia 200 une architecture réseau évolutive à deux niveaux reposant sur le protocole Ethernet, évitant ainsi les solutions propriétaires souvent trop onéreuses. Chaque accélérateur dispose d'une bande passante bidirectionnelle de 2,8 To/s, permettant de connecter jusqu'à 6 144 unités au sein d'un même cluster de calcul. Cette interconnexion massive assure une coordination parfaite lors des opérations collectives lourdes, garantissant une prévisibilité des performances même sous une charge de travail intense. Le déploiement dans le centre de données de l'Iowa n'est que la première étape d'une couverture mondiale qui s'étendra rapidement à d'autres régions Azure.

La simplicité de cette structure facilite grandement la maintenance et l'évolution des parcs de serveurs existants.

À l'intérieur de chaque baie, les puces communiquent entre elles via des liaisons directes non commutées pour réduire la latence au minimum.

Ce protocole de transport personnalisé, baptisé Maia AI, unifie les communications entre les nœuds, les racks et les clusters entiers sans multiplier les sauts réseau inutiles. Cette approche simplifie considérablement la programmation pour les développeurs tout en améliorant la flexibilité des charges de travail distribuées. En réduisant les capacités de calcul inutilisées par une meilleure répartition des tâches, Microsoft optimise le coût total de possession de ses infrastructures. L'intégration native avec le plan de contrôle Azure apporte en plus une télémétrie de précision et une sécurité accrue directement au niveau du silicium.

Cette maîtrise du réseau permet de déployer des grappes de serveurs fonctionnelles en un temps record par rapport aux standards de l'industrie.

Vers une intégration logicielle et matérielle sans couture

Le succès d'un nouveau matériel dépend inévitablement de la qualité des outils mis à disposition des ingénieurs pour l'exploiter.

Le kit de développement logiciel de la Maia 200 arrive avec une panoplie complète incluant le support de PyTorch et un compilateur Triton hautement optimisé. Ce SDK permet aux développeurs de porter leurs modèles existants avec une facilité déconcertante tout en offrant un accès bas niveau pour ceux qui exigent un contrôle total. La présence d'un simulateur intégré et d'un calculateur de coûts permet d'anticiper l'efficacité du code avant même son exécution sur le matériel physique. Cette volonté d'ouverture logicielle est cruciale pour attirer les startups et les chercheurs dans l'écosystème Azure au détriment de la concurrence.

Microsoft mise sur une adoption rapide en facilitant chaque étape du cycle de vie du code IA.

Le programme Maia s'inscrit dans une vision multigénérationnelle où chaque nouvelle puce doit repousser les limites de la physique et de l'économie.

L'arrivée de la Maia 200 n'est que le prélude à une série d'accélérateurs qui définiront le paysage technologique de la fin de la décennie. En validant l'ensemble du système, du refroidissement liquide de deuxième génération jusqu'aux bibliothèques de noyaux, la firme s'assure une longueur d'avance sur les imprévus techniques. Les modèles d'IA étaient d'ailleurs opérationnels sur ces puces seulement quelques jours après la réception des premiers composants, un délai divisé par deux par rapport aux projets précédents. Cette vélocité opérationnelle témoigne de la maturité atteinte par les équipes de conception matérielle de Redmond.

L'ère de l'IA à l'échelle planétaire exige une infrastructure qui ne laisse aucune place à l'approximation ou à la dépendance technologique.

À propos de l'auteur : Claude Jean est un professionnel aguerri de l'équipement domestique. Fort d'une carrière de plus de 25 ans à la tête d'un magasin spécialisé en high tech et en bricolage/motoculture, il maîtrise aussi bien les technologies de l'image et du son que les innovations du secteur jardinage. Son approche est pragmatique : tester le matériel pour en extraire la valeur réelle pour l'utilisateur.